目录

在人工智能浪潮席卷全球的今天,无论是技术爱好者还是行业从业者,都面临着如何系统学习这一复杂领域的挑战。本文简述了 AI 的基础概念,为你揭开 AI 世界的神秘面纱,帮助你建立坚实的知识基础,为未来的深入学习铺平道路。

理解人工智能语言处理的核心

AI(人工智能) 是让机器模拟人类智能行为的科学与工程。它涵盖了从简单的规则系统到复杂的深度学习模型。

传统编程指令 vs 机器学习

传统编程

定义:

传统编程是一种通过明确的指令和规则来告诉计算机如何完成任务的编程方式。程序员需要详细地编写每一步操作的代码,计算机会严格按照这些指令执行。

特点:

- 明确的规则: 程序员需要明确地定义每个步骤和规则。

- 确定性: 给定相同的输入,程序会始终产生相同的输出。

- 依赖专家知识: 需要程序员对问题领域有深入的理解,以便编写详细的逻辑和规则。

例子:

假设我们要编写一个程序来判断一个数字是奇数还是偶数。

pythondef is_even(number):

if number % 2 == 0:

return True

else:

return False

在这个例子中,程序员明确地定义了如何判断一个数字是偶数(即数字除以2余数为0)。

机器学习

定义:

机器学习是一种通过数据训练模型,使计算机能够自动从数据中学习模式和规律的编程方式。程序员不需要明确地编写每一步操作的代码,而是通过提供大量的示例数据,让计算机自行学习。

特点:

- 数据驱动: 依赖大量的数据来训练模型。

- 不确定性: 给定相同的输入,输出可能会有所不同,取决于模型的训练和随机因素。

- 自动化学习: 计算机通过数据自主学习,不需要明确的规则定义。

例子:

假设我们要训练一个模型来判断一张图片中是否有猫。我们可以使用一个包含大量猫和非猫图片的训练集,通过机器学习算法(如卷积神经网络)来训练模型。

训练集(Training Set)用于训练机器学习模型的数据集。它包含输入数据和对应的目标标签,模型通过学习这些数据中的模式和规律来调整其参数

测试集(Test Set):用于评估机器学习模型性能的数据集。它包含输入数据和对应的目标标签,但这些数据在模型训练过程中是不可见的。

pythonfrom sklearn.model_selection import train_test_split

from sklearn.ensemble import RandomForestClassifier

from sklearn.datasets import load_digits

# 加载数据集

digits = load_digits()

X = digits.data

y = digits.target

# 划分训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

# 训练模型

model = RandomForestClassifier()

model.fit(X_train, y_train)

# 预测

predictions = model.predict(X_test)

在这个例子中,我们使用了一个现成的数据集和机器学习模型(随机森林分类器),通过训练数据来让模型自动学习如何分类数字。

传统编程 vs 机器学习

1. 编程方式:

- 传统编程: 程序员编写明确的规则和指令。

- 机器学习: 程序员提供数据和算法,模型通过学习数据中的模式来做出决策。

2. 适用场景:

- 传统编程: 适用于规则明确、逻辑清晰的问题,如计算公式、数据处理等。

- 机器学习: 适用于规则复杂、难以明确定义的问题,如图像识别、语音识别、推荐系统等。

3. 处理方式:

- 传统编程: 需要详细的步骤和逻辑,依赖人类专家的知识。

- 机器学习: 依赖大量数据,通过学习数据中的模式和规律来做出决策。

NL(自然语言)

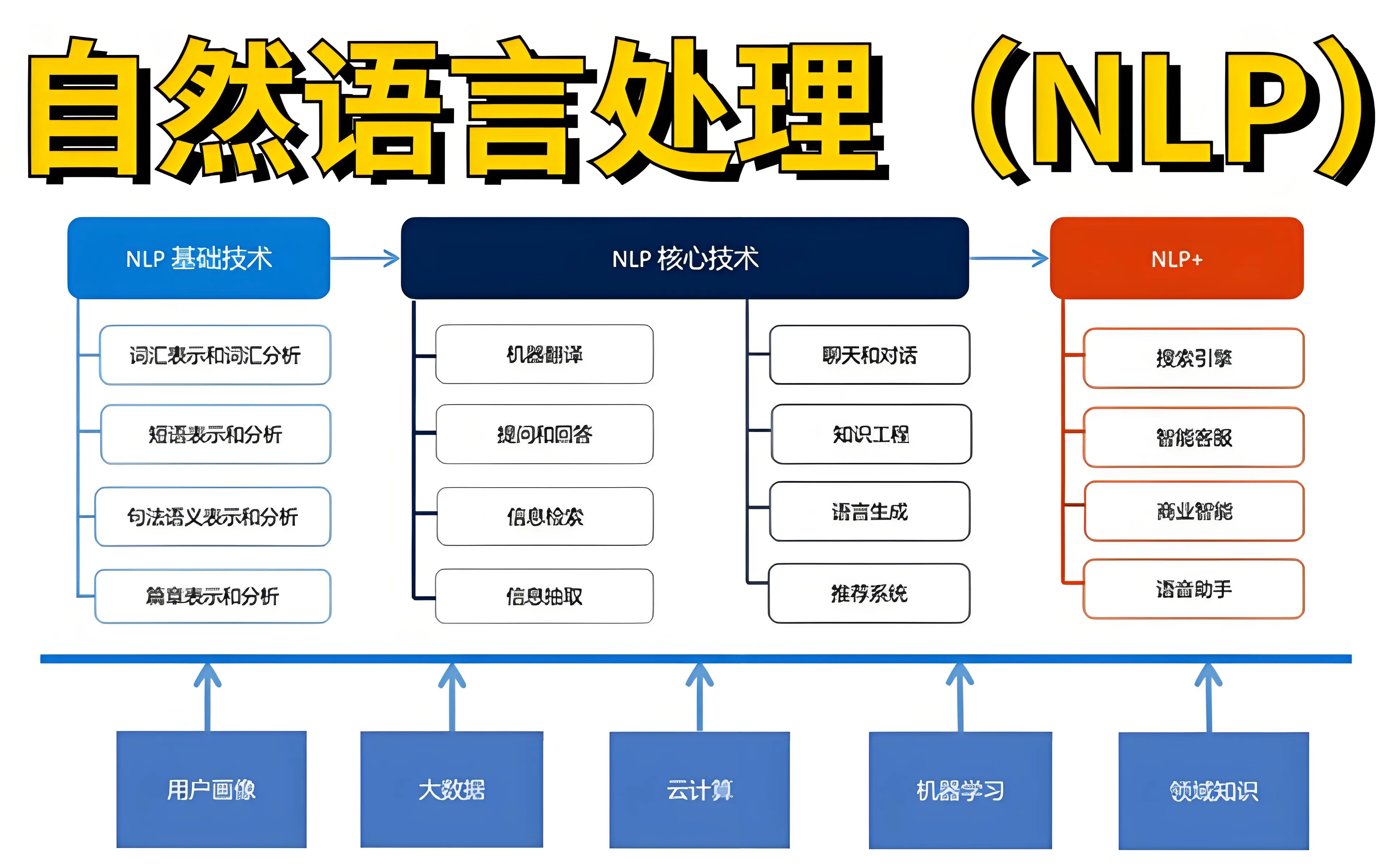

自然语言处理(NLP)

定义:

自然语言处理(Natural Language Processing, NLP)是计算机科学和人工智能的一个子领域,致力于实现计算机对人类语言的理解、解读和生成。NLP涵盖了从文本处理到语音识别的广泛任务。

例子:

- 文本分类: 电子邮件过滤系统可以使用NLP来自动将邮件分类为“垃圾邮件”或“非垃圾邮件”。

- 情感分析: 社交媒体监控工具可以使用NLP来分析用户评论的情感倾向(正面、负面或中性)。

自然语言理解(NLU)

定义:

自然语言理解(Natural Language Understanding, NLU)是NLP的一个子领域,专注于使计算机能够理解和解释人类语言的含义。NLU涉及语义分析、意图识别、实体识别等任务。

例子:

- 意图识别: 在智能语音助手中,当用户说“帮我订一张明天去纽约的机票”,系统需要识别用户的意图是“订票”。

- 实体识别: 在同一句话中,系统需要识别出“纽约”是一个地名,“明天”是一个时间表达。

自然语言生成(NLG)

定义:

自然语言生成(Natural Language Generation, NLG)是NLP的另一个子领域,旨在使计算机能够生成自然、人类可读的语言文本。NLG通常用于自动报告生成、内容创作等场景。

例子:

- 自动报告: 金融分析工具可以使用NLG来生成每日或每周的市场分析报告。

- 内容创作: 新闻自动写作系统可以根据输入的数据生成新闻文章,如体育比赛的赛后报道。

通俗易懂的例子

假设我们有一个智能语音助手(如Siri或Alexa),以下是NLP、NLU和NLG在其中的具体应用:

- 用户输入: 用户说:“明天的天气怎么样?”

- 自然语言处理(NLP):

- 语音识别: 首先将用户的语音转换为文本:“明天的天气怎么样?”

- 文本预处理: 清理和规范化文本,如去除多余的空格或标点。

- 自然语言理解(NLU):

- 意图识别: 系统识别用户的意图是询问天气。

- 实体识别: 系统识别出“明天”是时间相关的实体。

- 数据处理: 系统查询天气数据库,获取“明天”的天气信息。

- 自然语言生成(NLG):

- 生成文本: 系统将查询结果转换为自然语言文本:“明天的天气是晴天,最高气温25度,最低气温15度。”

- 语音合成: 将生成的文本转换为语音,并播放给用户。

关系总结:AI > NLP > (NLU + NLG),NL是所有这些技术处理的对象。通过这个例子,可以看到NLP、NLU和NLG如何协同工作来实现一个完整的自然语言交互过程。

机器学习:从数据中学习的科学

学习方法分类

监督学习: 模型从带有标签的数据中学习。就像学生通过带有答案的习题集学习。

-

应用:垃圾邮件分类、房价预测

-

算法:线性回归、决策树、支持向量机

无监督学习: 模型从无标签数据中发现模式。就像学生自己从杂乱的信息中总结规律。

-

应用:客户分群、异常检测

-

算法:K-means聚类、主成分分析

强化学习: 智能体通过与环境交互学习最优策略。就像训练宠物,做对给奖励,做错给惩罚。

-

应用:AlphaGo、自动驾驶

-

算法:Q-learning、策略梯度

拟合评估:平衡学习的"度"

欠拟合: 模型过于简单,无法捕捉数据中的复杂模式。

-

表现:在训练集和测试集上都表现不佳

-

解决:增加模型复杂度、添加特征

过拟合: 模型过于复杂,过度适应训练数据中的噪声。

-

表现:训练集上表现好,测试集上表现差

-

解决:增加数据量、正则化、简化模型

恰当拟合: 理想状态,模型既捕捉到了数据规律,又具有良好的泛化能力。

评估指标: 准确率、精确率、召回率、F1分数等。

神经网络:模仿人脑的计算模型

CNN(卷积神经网络) - 图像处理的王者

核心思想: 通过卷积核在图像上滑动,提取局部特征。

关键组件:

-

卷积层:特征提取

-

池化层:降维,保留重要特征

-

全连接层:最终分类

应用: 图像分类、目标检测、人脸识别

优势: 参数共享、平移不变性

RNN(循环神经网络) - 序列数据的专家

核心思想: 具有记忆功能,能够处理序列数据。

关键特性:

-

隐藏状态:保留之前时间步的信息

-

循环连接:信息在时间维度上传递

-

局限:梯度消失/爆炸问题,难以学习长期依赖

应用: 文本生成、时间序列预测

Transformer - 现代NLP的基石

革命性创新: 自注意力机制,彻底改变了序列建模。

核心组件:

-

自注意力机制:同时关注输入序列的所有位置

-

位置编码:为模型提供序列中词语的位置信息

-

编码器-解码器架构

优势: 并行计算能力强,能够捕捉长距离依赖

BERT - 理解语言的双向专家

核心特点: 基于Transformer编码器,双向预训练

训练技术:

-

掩码语言模型:随机遮盖词语让模型预测

-

下一句预测:判断两个句子是否连续

应用: 文本分类、问答系统、情感分析

向量数据库

在人工智能(AI)领域,特别是在处理自然语言或图像等数据时,经常需要将原始数据转换成向量形式。这些向量通常称为特征向量,它们是原始数据的数值表示,可以用于各种机器学习模型的训练和预测。为了高效管理和检索这些向量,我们会使用向量数据库。

向量数据库的理解:

向量数据库是专门设计来存储、管理和检索向量数据的数据库。在传统的数据库中,数据通常以表格形式存储,如一行行的数据记录。而向量数据库则更适合处理形式为多维数组的数据,它们能够支持在这些向量集合上执行复杂的查询,比如寻找与给定向量最相似的向量。

为什么需要向量数据库?

- 高效检索:在AI应用如推荐系统或图像识别中,快速找到与输入数据相似的历史数据是很重要的。向量数据库通过优化数据结构,加速这种“最近邻”搜索。

- 大规模存储:AI训练和应用中常常涉及到大量的向量数据,传统数据库在处理如此大规模的高维数据时效率不高。向量数据库专为这种需求设计,提供更好的存储解决方案。

- 动态更新:在许多应用场景中,向量数据需要不断更新或扩展,向量数据库可以高效处理这些动态变化的数据集。

例子说明:

- 图像搜索:在一个在线购物网站上,顾客可以上传一张他们喜欢的衣服的图片,系统将返回看起来类似的产品。每个产品的图片在存入数据库之前,首先被转换成一个特征向量。当顾客上传图片时,系统也同样将这张图片转换为向量,然后在向量数据库中搜索最接近的向量,从而找到并推荐相似的商品。

- 推荐系统:在音乐流媒体服务中,为了推荐与你过去喜欢的歌曲类似的新歌曲,系统需要对所有歌曲的音频文件进行分析,将它们转换为特征向量。这些向量储存在向量数据库中,当用户播放某首歌时,系统即检索出与当前歌曲特征向量最相似的其他歌曲向量,实现个性化推荐。

- 面部识别:安全系统利用面部识别技术来验证个人身份。系统首先将数据库中每个人的面部图像转换为向量,存储在向量数据库中。当有人尝试进入受保护的场所时,系统把此人的面部图像也转为向量,快速在数据库中寻找匹配项,若找到相似度高的向量,则允许进入。

通过上述例子,可以看到向量数据库在处理和检索大量高维数据方面的重要性,它是许多现代 AI 系统能够高效运作的关键技术之一。

嵌入(Embeddings)

嵌入(Embeddings)是一种常用的技术,特别是在自然语言处理(NLP)和机器学习领域中,用于将文本、图像等非数值形式的数据转换成数值向量。这些数值向量可以被计算机更好地理解和处理。

嵌入的基本概念:

这些向量不是随机的数字,而是通过学习得到的,它们捕捉并表达了原始数据的重要特性和关系。比如在文本处理中,单词的嵌入向量会捕捉到单词的语法和语义特性。

为什么要使用嵌入?

- 降维:原始数据如单词、用户ID或商品ID等可能有成千上万的唯一值。如果直接处理这些数据,需要非常大的空间和计算资源。嵌入能够将这些大规模的分类数据压缩到较小的、连续的数值空间中。

- 捕获关系:嵌入通过训练学习数据中的关系,例如在文本中,经常共同出现的单词在向量空间中彼此会更接近。

例子说明:

- 单词嵌入:

- 假设你有三个单词:“狗”,“猫”,“汽车”。在没有嵌入的情况下,这三个词是完全不同的,没法比较它们之间的相似性。但如果经过合适的训练,我们可以得到一个向量空间,其中“狗”和“猫”的向量会因为它们都是宠物而彼此更接近,而和“汽车”则距离较远。

- 商品嵌入:

- 在推荐系统中,如果用户A喜欢商品x, y, z, 而用户B喜欢商品x, y,通过商品的嵌入向量,我们可以计算出B很可能也会喜欢商品z,从而向B推荐z。

- 图像嵌入:

- 在面部识别技术中,系统会将每个人的面部图像转换成一个数值向量。当需要验证用户身份时,只需将此时的面部图像也转为向量,然后与数据库中存储的向量进行比较,查看是否匹配。

通过嵌入技术,我们可以更有效地处理和分析各种复杂的数据,这在其他形式的机器学习任务中也有广泛的应用。总之,嵌入是将大量复杂的数据点转化为易于操作的数值形式的有效工具。

当然,可以用简单的语言来解释这些机器学习的基本概念和不同类型,并通过一些例子来帮助理解。GPT(Generative Pre-trained Transformer)是一种先进的自然语言处理模型,它能生成类似于人类写作的文本。这个名字的每个部分都代表了它的独特功能和结构。让我们逐步解释每个部分,并通过简单的语言和例子来帮助你理解。

LLM、Generative AI:生成式AI的新纪元

LLM(大语言模型)

定义: 基于Transformer架构,在海量文本数据上训练的巨大神经网络。

特点:

-

参数量巨大(数亿到数万亿)

-

强大的语言理解和生成能力

-

涌现能力:随着规模增大出现的新能力

代表模型: GPT系列、LLaMA、ChatGLM

Generative AI(生成式AI)

定义: 能够创造新内容(文本、图像、音频等)的AI系统。

与判别式AI的区别:

-

判别式AI:区分猫和狗(分类)

-

生成式AI:画出一只猫(创造)

应用领域:

-

文本生成:写作助手、代码生成

-

图像生成:AI绘画、设计创作

-

音频生成:语音合成、音乐创作

OpenAI及其他常用大模型的使用

OpenAI GPT系列:

-

GPT-3.5:支持ChatGPT的基础模型

-

GPT-4:更强的推理和专业知识能力

-

GPT-4 Turbo:性价比更高的版本

使用方式:

pythonfrom openai import OpenAI

client = OpenAI()

response = client.chat.completions.create(

model="gpt-3.5-turbo",

messages=[{"role": "user", "content": "你好!"}]

)

其他主流模型

-

Deepseek: 超强

-

文心一言(百度):中文理解强

-

通义千问(阿里):多模态能力

-

智谱GLM:双语支持好

选择考量因素

-

任务需求:创意写作、代码生成、逻辑推理

-

成本预算:API费用、自建成本

-

数据安全:云端API vs 本地部署

-

语言支持:中文能力、多语言需求

Python开发环境:AI工程师的工具体系

核心库生态

数据处理:

-

NumPy:数值计算基础

-

Pandas:数据分析利器

-

Matplotlib/Seaborn:数据可视化

机器学习:

-

Scikit-learn:传统机器学习算法

-

XGBoost/LightGBM:梯度提升框架

深度学习:

-

PyTorch:研究首选,动态图

-

TensorFlow:工业部署,静态图

大模型相关:

-

Transformers(Hugging Face):预训练模型库

-

LangChain:AI应用框架

-

OpenAI:官方API库

掌握基础概念,才知"怎么做"

举例说明:

-

了解Transformer架构(基础概念) → 能更好理解为什么某些提示词有效(核心掌握)

-

理解温度参数原理(基础概念) → 能更准确调试生成效果(核心掌握)

-

知道BERT的双向机制(基础概念) → 能更好设计RAG系统(核心掌握)

学习建议:

-

先建立基础概念框架,形成技术直觉

-

然后深入核心掌握的实践技能

-

在实践中遇到问题时,回查基础概念寻找答案

-

形成"理论指导实践,实践验证理论"的良性循环

本文作者:柳始恭

本文链接:

版权声明:本博客所有文章除特别声明外,均采用 BY-NC-SA 许可协议。转载请注明出处!